linux环境部署清华大学大模型最新版 chatglm2-6b 图文教程

准备工作:

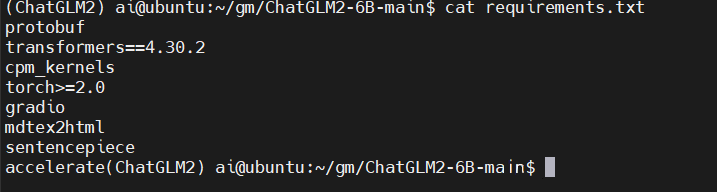

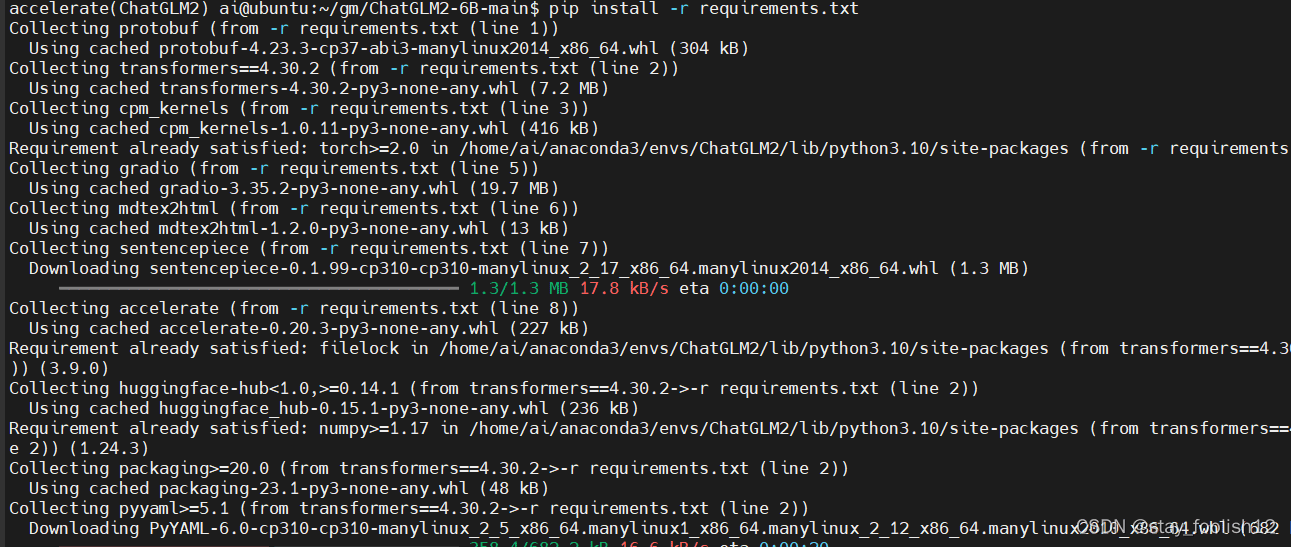

# 下载项目源代码 git clone https://github.com/THUDM/ChatGLM2-6B # 切换到项目根目录 cd ChatGLM2-6B # 安装依赖 pip install -r requirements.txt # 安装web依赖 pip install gradio

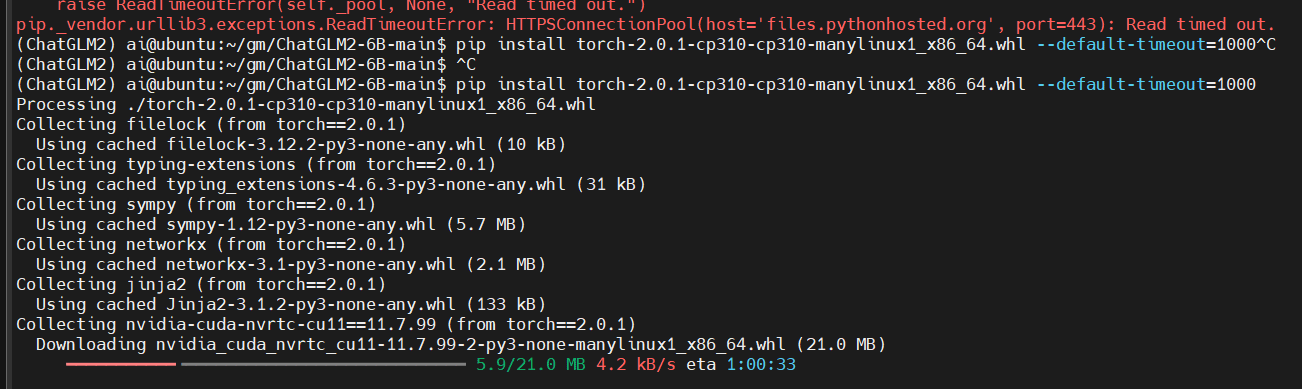

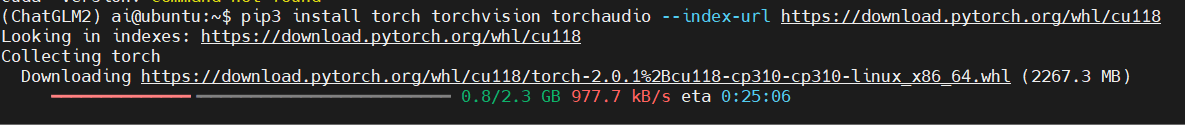

如果安装出现问题,可尝试手动分别安装torch

1 # 1第一步安装虚拟环境并激活环境

conda create -n ChatGLM2 python=3.10.6 conda activate ChatGLM2

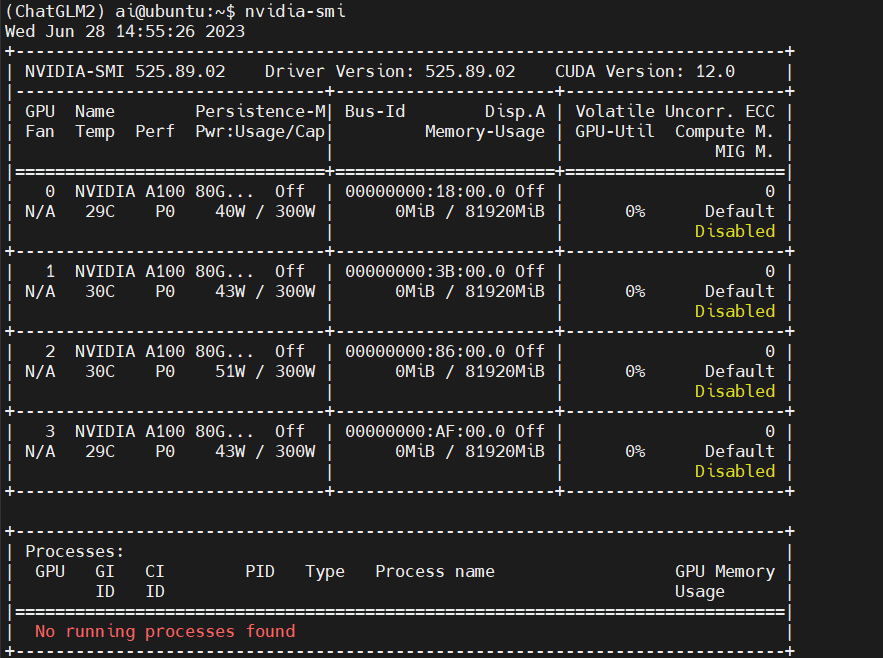

2 nvidia-smi查看cuda版本,12.0

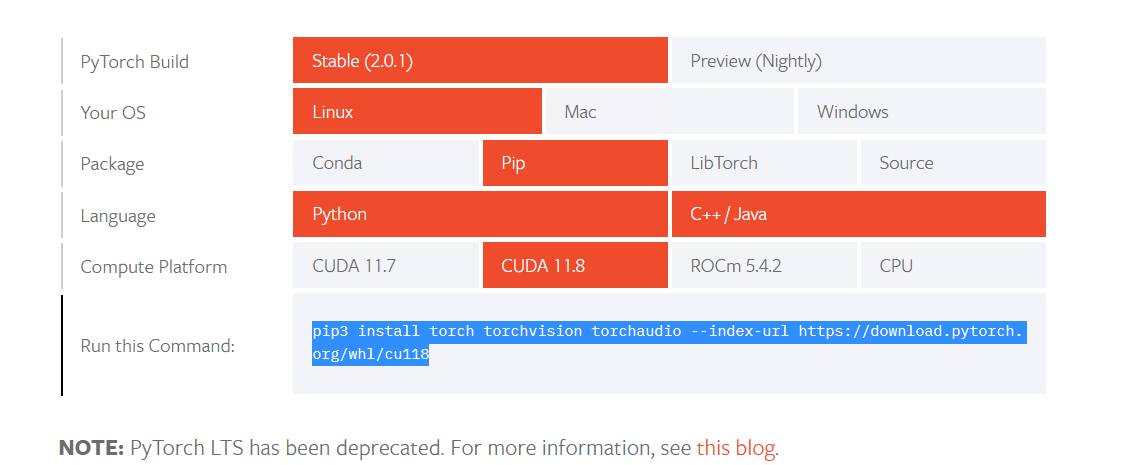

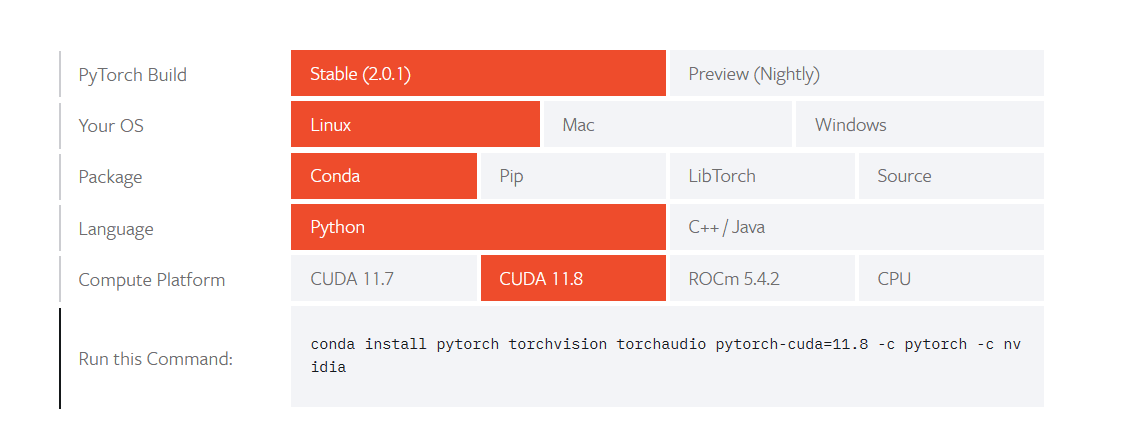

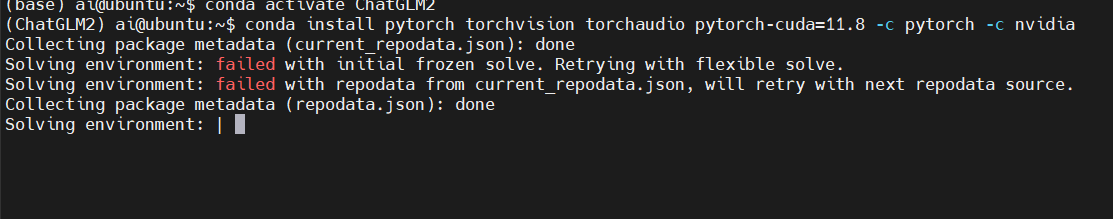

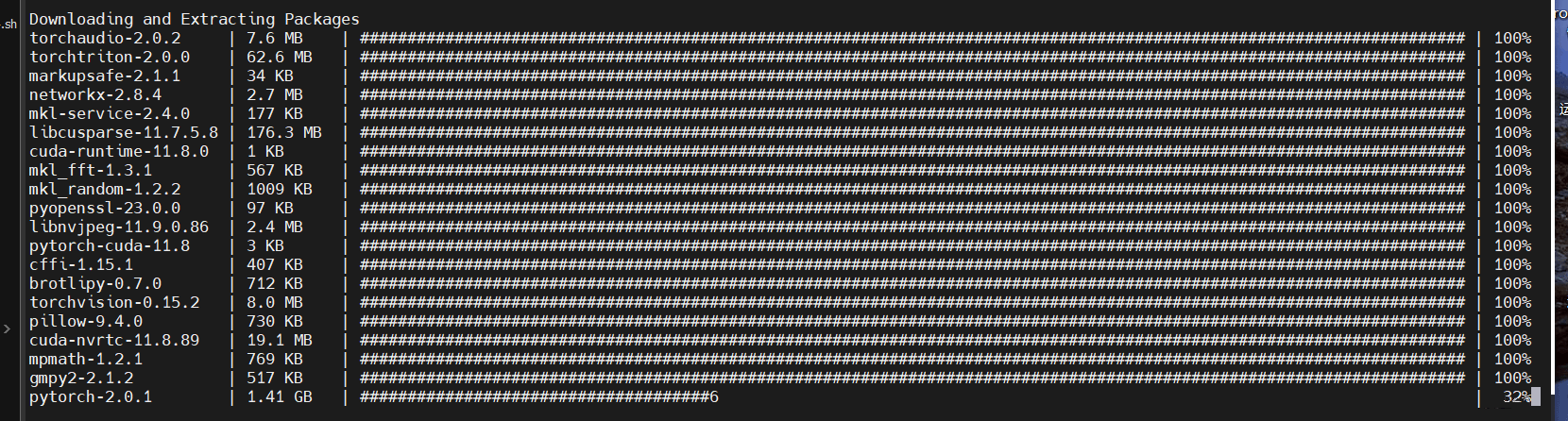

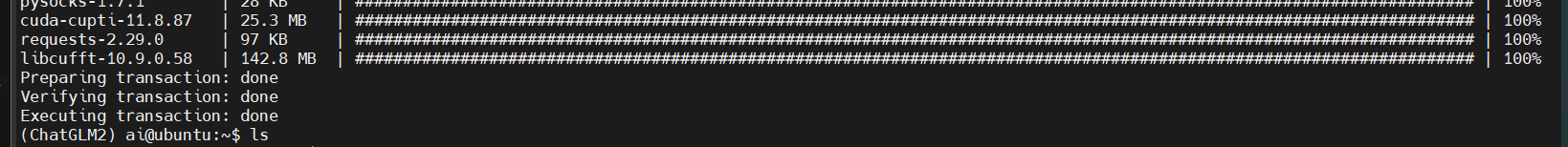

3 安装torch第一种方式

pytorch官网:https://pytorch.org/

经过多次尝试,发现conda装,真的很快,真香。前几次尝试用pip装torch都会出现timeout的错误,这个跟服务器有关系,视情况而定。

# 安装依赖 pip install -r requirements.txt

二、准备工作。安装依赖包的同时,也可以先手动下载模型包:

1、工程文件准备

整个工程需要从两个远程仓库克隆,一个是 github 上的源码,一个是 HuggingFace 上的模型。

对于源码,由于总体积较小,因此可直接从网页下载 zip 包后解压,也可使用 git 命令(电脑需要提前装好 git )克隆至本地文件夹中:

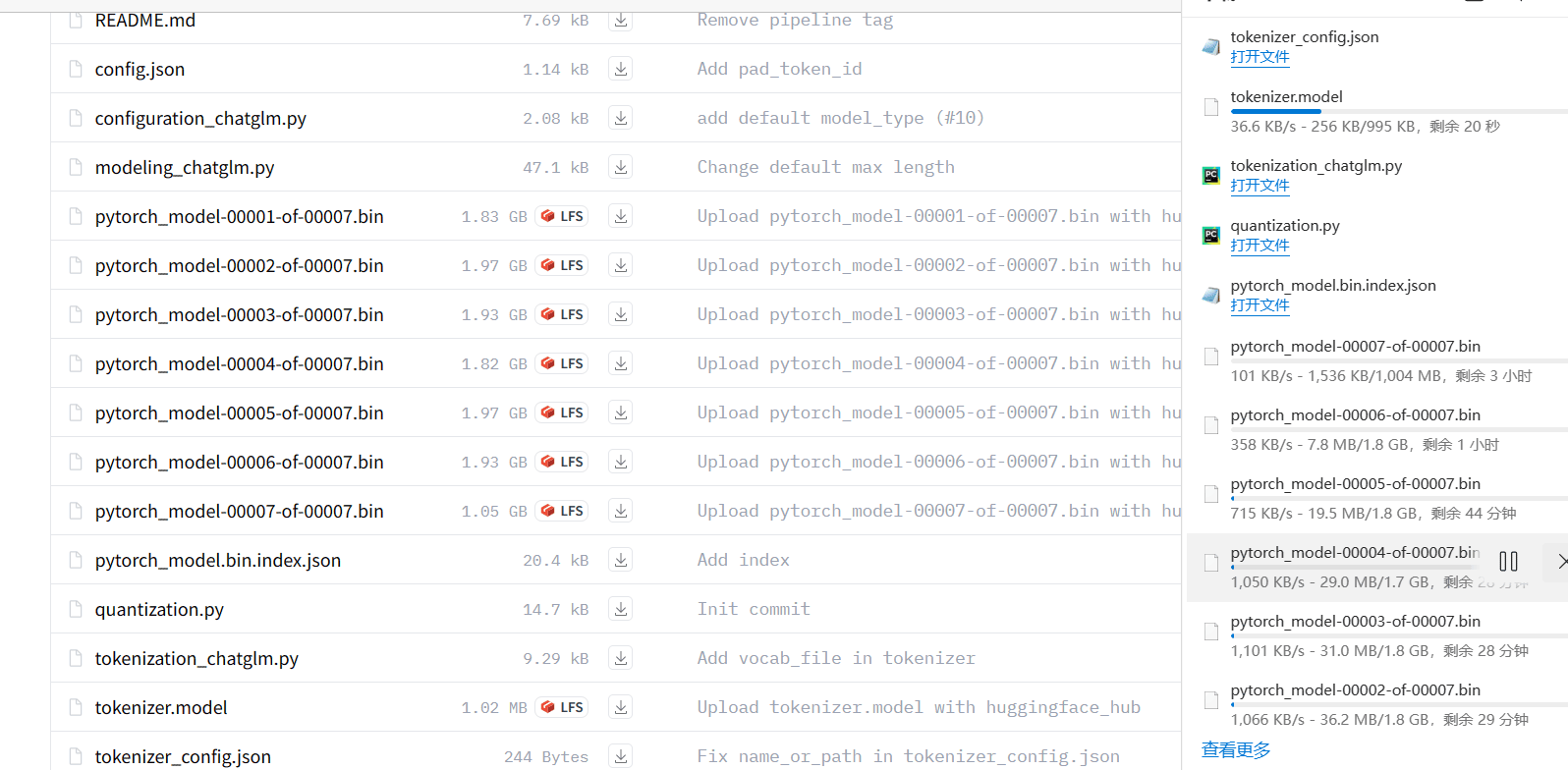

git clone https://github.com/THUDM/ChatGLM2-6B

对于模型,由于存在7个体积较大的 checkpoint 文件,若直接 clone 可能耗时过久或网络连接不够稳定,可以采用大、小文件分别下载的方式。其中大文件可从 清华云 手动下载,小文件主要为模型实现文件,数量不多且体积较小(算上 tokenizer.model 一共11个文件),可采用两种方式下载,一种是在 HuggingFace 页面手动一个一个下载,另一种是利用 GIT_LFS_SKIP_SMUDGE 参数跳过大文件一次性克隆整个工程(电脑需要提前装好 Git LFS):

GIT_LFS_SKIP_SMUDGE=1 git clone https://huggingface.co/THUDM/chatglm2-6b

最后再将前面手动下载好的大文件拷入替换,构成完整的模型。

需要注意的坑:

1)该命令在 powershell 中会报错,提示不认识 GIT_LFS_SKIP_SMUDGE 命令,放在 git bash 终端中则可顺利执行; 2)被该命令跳过的“大文件”不仅有 7 个 .bin 文件,还包括 1.02MB 的 tokenizer.model。

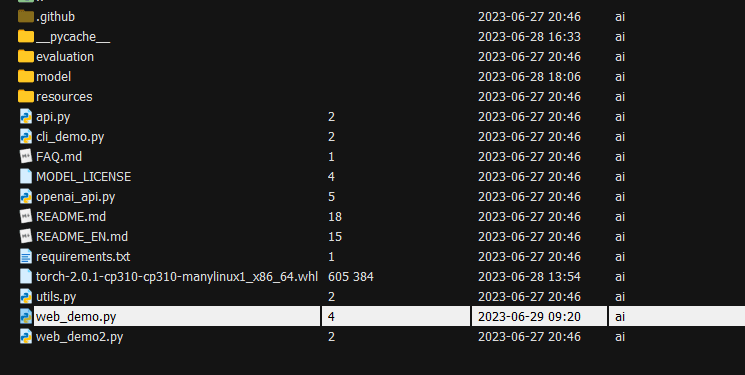

模型文件理论上可存放于任意位置,参考官方演示视频将其平行于源码文件夹,即整个工程文件的目录结构如下:

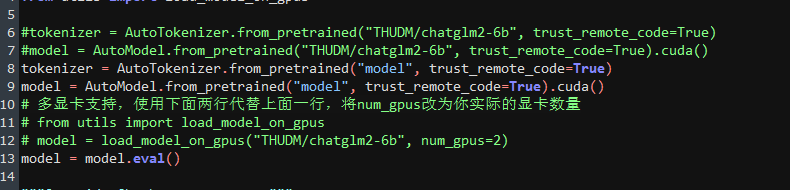

根据目录结构,修改源码目录下的 web_demo.py 文件,将两处 THUDM/chatglm2-6b 替换为 model :

tokenizer = AutoTokenizer.from_pretrained("model", trust_remote_code=True)

model = AutoModel.from_pretrained("model", trust_remote_code=True).cuda()

如果想使用命令行与模型交互,则需要修改 cli_demo.py。web_demo2.py 同理 。

三、运行模型

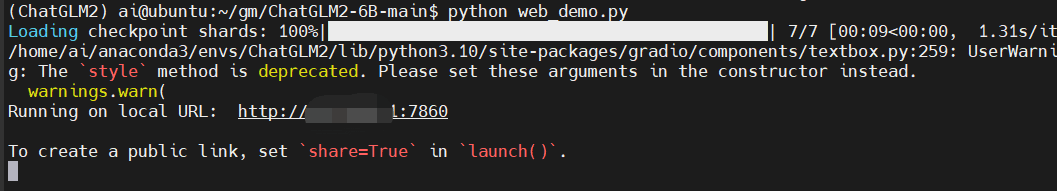

文件夹层面 cd 至web_demo.py文件夹,环境层面激活 chatglm2-6b,然后执行:

python web_demo.py

运行完之后就会弹出该页面:

运行完之后就会弹出该页面:

需要注意的坑:

1)使用 web_demo 时不能开 VPN,否则会弹出 Expecting value: line 1 column 1 (char 0)错误;

2)如使用 web_demo2,则需要按官网提示额外安装 streamlit 和 streamlit-chat,且启动命令为

streamlit run web_demo2.py 。

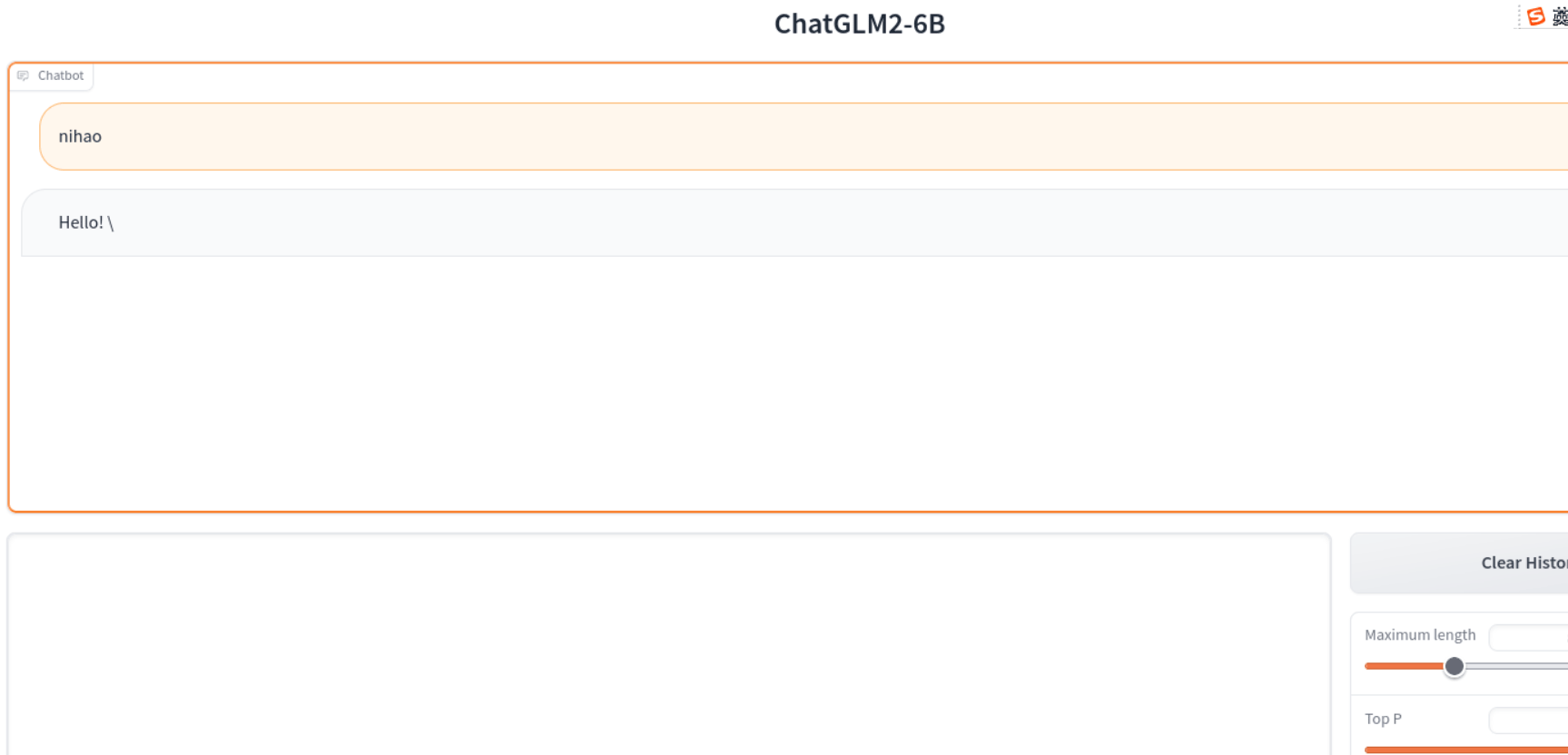

四、体验

推理速度相比上一代有明显的提升,但性能提升感知不强。期待团队未来推出13B、30B、65B等更大规模的模型。

注:笔者测试期间,第三方库的安装会因为网络原因出现一些问题,此时可以使用国内镜像来解决,例如,笔者在安装时使用的是阿里云镜像

pip install torchvision -i https://mirrors.aliyun.com/pypi/simple

相关文章

Django-celery-beat动态添加周期性任务实现过程解析

这篇文章主要介绍了Django-celery-beat动态添加周期性任务实现过程解析,文中通过示例代码介绍的非常详细,对大家的学习或者工作具有一定的参考学习价值,需要的朋友可以参考下2020-11-11

Tensorflow矩阵运算实例(矩阵相乘,点乘,行/列累加)

今天小编就为大家分享一篇Tensorflow矩阵运算实例(矩阵相乘,点乘,行/列累加),具有很好的参考价值,希望对大家有所帮助。一起跟随小编过来看看吧2020-02-02

python中利用await关键字如何等待Future对象完成详解

为了简化并更好地标识异步IO,从Python 3.5开始引入了新的语法async和await,可以让coroutine的代码更简洁易读。下面这篇文章主要给大家介绍了关于python中利用await关键字如何等待Future对象完成的相关资料,需要的朋友可以参考下。2017-09-09

最新评论