Python Requests爬虫之求取关键词页面详解

更新时间:2022年02月16日 10:10:18 作者:那人独钓寒江雪.

这篇文章主要为大家详细介绍了Python Requests爬虫之求取关键词页面,文中示例代码介绍的非常详细,具有一定的参考价值,感兴趣的小伙伴们可以参考一下,希望能够给你带来帮助

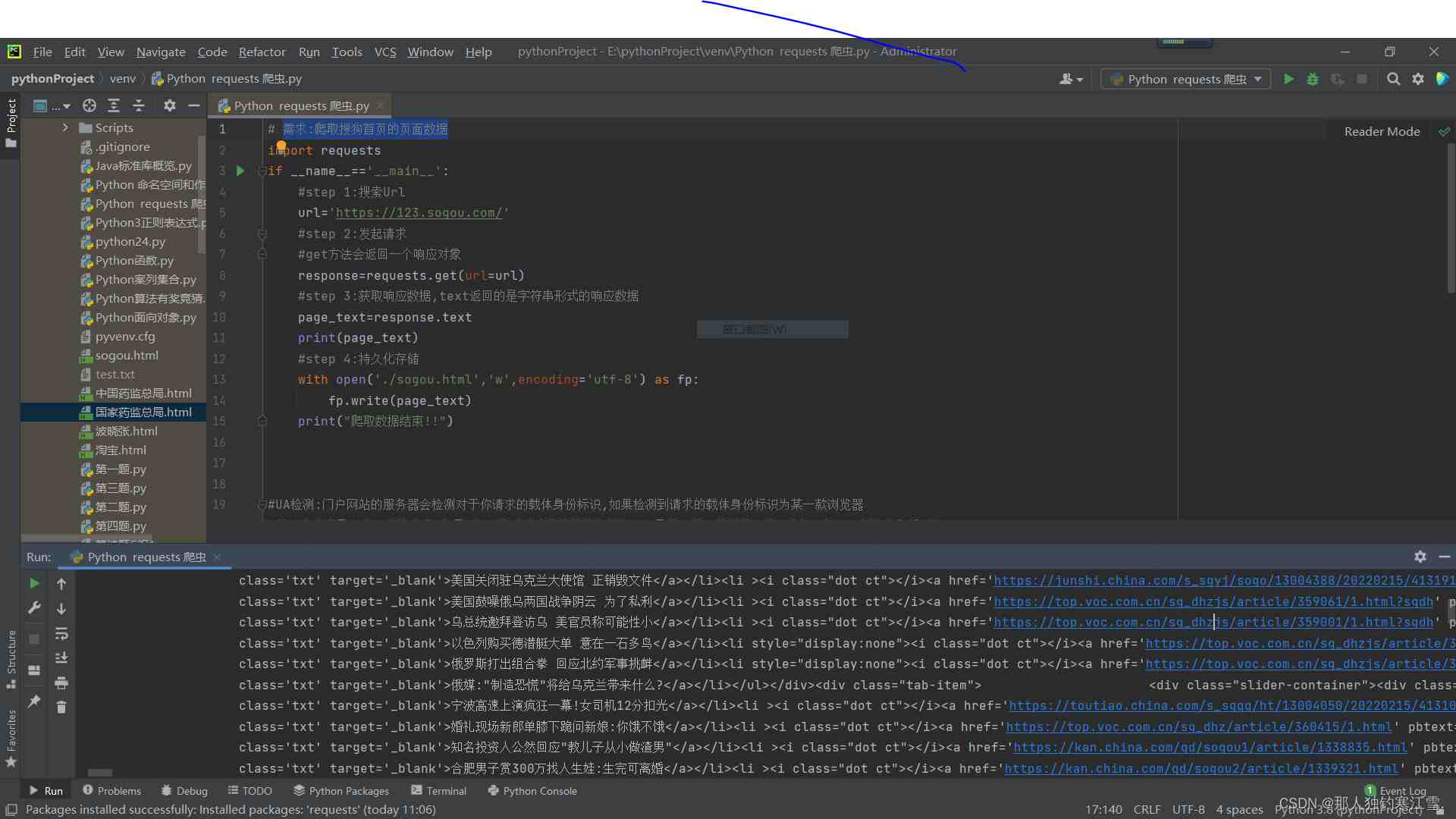

需求:爬取搜狗首页的页面数据

import requestsif __name__=='__main__': #step 1:搜索Url url='https://123.sogou.com/' #step 2:发起请求 #get方法会返回一个响应对象 response=requests.get(url=url) #step 3:获取响应数据,text返回的是字符串形式的响应数据 page_text=response.text print(page_text) #step 4:持久化存储 with open('./sogou.html','w',encoding='utf-8') as fp: fp.write(page_text) print("爬取数据结束")import requests

if __name__=='__main__':

#step 1:搜索Url

url='https://123.sogou.com/'

#step 2:发起请求

#get方法会返回一个响应对象

response=requests.get(url=url)

#step 3:获取响应数据,text返回的是字符串形式的响应数据

page_text=response.text

print(page_text)

#step 4:持久化存储

with open('./sogou.html','w',encoding='utf-8') as fp:

fp.write(page_text)

print("爬取数据结束")

使用UA伪装 求取关键词页面

import requests

if __name__=='__main__':

#UA伪装:将对应的User-Agent封装到一个字典中

headers={

'User-Agent':'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/98.0.4758.9 Safari/537.36'

}

url='https://www.sogou.com/sie?'

#处理url携带的参数:封装到字典中

kw=input('enter a word:')

param={

'query':kw

}

#对指定的url发起的请求对应的url是携带参数的,并且请求过程中处理了参数

response=requests.get(url=url,params=param,headers=headers)#headers是伪装 params输入关键词

page_text=response.text#以文本的形式输出

fileName=kw+'.html'#存储为网页形式

with open(fileName,'w+',encoding='utf-8') as fp:

fp.write(page_text)#写入fp

print(fileName,"保存成功!!")

总结

本篇文章就到这里了,希望能够给你带来帮助,也希望您能够多多关注脚本之家的更多内容!

相关文章

Python如何利用xlrd和xlwt模块操作Excel表格

这篇文章主要给大家介绍了关于Python如何利用xlrd和xlwt模块操作Excel表格的相关资料,其中xlrd模块实现对excel文件内容读取,xlwt模块实现对excel文件的写入,需要的朋友可以参考下2022-03-03

详解如何在VS Code中安装Spire.PDF for Python

这篇文章主要为大家详细介绍了如何在VS Code中安装Spire.PDF for Python,文中的示例代码简洁易懂,有需要的小伙伴可以跟随小编一起学习一下2023-10-10

最新评论