Python使用vllm处理多模态数据的预处理技巧

1. 背景介绍

1.1 目的和范围

本文旨在系统性地介绍在Python环境中使用vLLM处理多模态数据的预处理技术。我们将覆盖从基础概念到高级技巧的全套流程,特别关注如何利用vLLM框架优化多模态数据处理效率。

1.2 预期读者

本文适合以下读者:

- 使用vLLM进行多模态模型开发的AI工程师

- 从事多模态学习研究的研究人员

- 希望优化数据处理流程的数据科学家

- 对大规模语言模型和多模态学习感兴趣的技术爱好者

1.3 文档结构概述

文章将从基础概念开始,逐步深入到具体实现和技术细节,最后探讨实际应用和未来发展方向。每个部分都包含理论解释和实际代码示例。

1.4 术语表

1.4.1 核心术语定义

- vLLM: 一个高效的大规模语言模型推理和服务框架

- 多模态数据: 包含多种类型(如文本、图像、音频等)的数据

- 预处理: 将原始数据转换为适合模型输入的格式的过程

1.4.2 相关概念解释

- 特征工程: 从原始数据中提取有意义的特征的过程

- 数据清洗: 处理缺失值、异常值等数据问题的过程

- 数据标准化: 将数据转换为统一尺度的过程

1.4.3 缩略词列表

- NLP: 自然语言处理

- CV: 计算机视觉

- ASR: 自动语音识别

- BPE: 字节对编码

2. 核心概念与联系

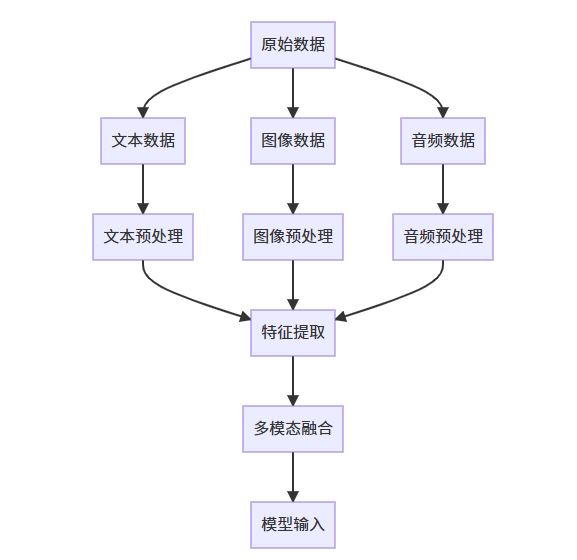

多模态数据处理的核心在于将不同类型的数据转换为统一的表示形式,以便模型能够同时处理和理解这些数据。vLLM框架通过其高效的推理引擎为多模态数据处理提供了强大的支持。

多模态数据预处理的关键步骤包括:

- 数据加载和解析

- 数据清洗和标准化

- 特征提取和转换

- 多模态对齐和融合

- 批处理和缓存优化

3. 核心算法原理 & 具体操作步骤

3.1 文本数据预处理

文本预处理是vLLM处理多模态数据的基础,主要包括以下步骤:

from vllm import LLM, SamplingParams

import re

from transformers import AutoTokenizer

def preprocess_text(text):

# 清洗文本

text = re.sub(r'[^\w\s]', '', text) # 去除标点

text = text.lower() # 转为小写

# 使用vLLM兼容的分词器

tokenizer = AutoTokenizer.from_pretrained("facebook/opt-1.3b")

tokens = tokenizer(text, return_tensors="pt", padding=True, truncation=True)

return tokens

# 示例使用

text_data = "This is an example of text preprocessing with vLLM."

processed_text = preprocess_text(text_data)

3.2 图像数据预处理

图像预处理需要考虑与文本数据的对齐:

from PIL import Image

import torchvision.transforms as transforms

def preprocess_image(image_path, target_size=(224, 224)):

# 加载图像

img = Image.open(image_path)

# 定义预处理流程

transform = transforms.Compose([

transforms.Resize(target_size),

transforms.ToTensor(),

transforms.Normalize(mean=[0.485, 0.456, 0.406],

std=[0.229, 0.224, 0.225]),

])

return transform(img)

# 示例使用

image_data = preprocess_image("example.jpg")

3.3 音频数据预处理

音频数据需要转换为适合模型输入的频谱表示:

import torchaudio

import torch

def preprocess_audio(audio_path, sample_rate=16000):

# 加载音频文件

waveform, sr = torchaudio.load(audio_path)

# 重采样

if sr != sample_rate:

resampler = torchaudio.transforms.Resample(sr, sample_rate)

waveform = resampler(waveform)

# 提取Mel频谱特征

mel_transform = torchaudio.transforms.MelSpectrogram(

sample_rate=sample_rate,

n_mels=128,

n_fft=2048,

hop_length=512

)

return mel_transform(waveform)

# 示例使用

audio_data = preprocess_audio("example.wav")

4. 数学模型和公式 & 详细讲解 & 举例说明

多模态数据处理涉及多个数学转换过程,以下是关键公式:

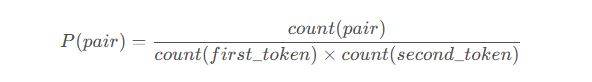

4.1 文本分词和嵌入

文本分词使用BPE算法,其数学表示为:

其中pair是待合并的token对,选择具有最高P(pair)的pair进行合并。

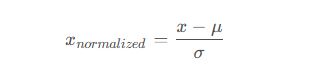

4.2 图像标准化

图像标准化使用以下公式:

其中μ是均值, σ是标准差,通常使用ImageNet数据集的统计量:

μ = [ 0.485 , 0.456 , 0.406 ],σ=[0.229,0.224,0.225]

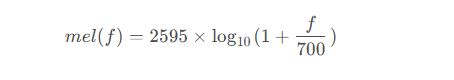

4.3 音频频谱转换

Mel频谱转换公式:

其中f是频率(Hz),将线性频率转换为Mel频率。

5. 项目实战:代码实际案例和详细解释说明

5.1 开发环境搭建

建议使用以下环境配置:

conda create -n vllm-multimodal python=3.9 conda activate vllm-multimodal pip install vllm torch torchvision torchaudio transformers pillow

5.2 源代码详细实现和代码解读

完整的多模态数据预处理流水线实现:

import os

from typing import Dict, Any

from dataclasses import dataclass

import torch

from transformers import AutoTokenizer

@dataclass

class MultiModalSample:

text: str = None

image_path: str = None

audio_path: str = None

class MultiModalPreprocessor:

def __init__(self, model_name="facebook/opt-1.3b"):

self.tokenizer = AutoTokenizer.from_pretrained(model_name)

self.image_transform = self._get_image_transform()

self.audio_transform = self._get_audio_transform()

def _get_image_transform(self):

return transforms.Compose([

transforms.Resize((224, 224)),

transforms.ToTensor(),

transforms.Normalize(mean=[0.485, 0.456, 0.406],

std=[0.229, 0.224, 0.225]),

])

def _get_audio_transform(self):

return torchaudio.transforms.MelSpectrogram(

sample_rate=16000,

n_mels=128,

n_fft=2048,

hop_length=512

)

def preprocess(self, sample: MultiModalSample) -> Dict[str, Any]:

processed = {}

if sample.text:

processed["text"] = self._process_text(sample.text)

if sample.image_path and os.path.exists(sample.image_path):

processed["image"] = self._process_image(sample.image_path)

if sample.audio_path and os.path.exists(sample.audio_path):

processed["audio"] = self._process_audio(sample.audio_path)

return processed

def _process_text(self, text: str) -> Dict[str, torch.Tensor]:

return self.tokenizer(

text,

return_tensors="pt",

padding=True,

truncation=True,

max_length=512

)

def _process_image(self, image_path: str) -> torch.Tensor:

img = Image.open(image_path).convert("RGB")

return self.image_transform(img)

def _process_audio(self, audio_path: str) -> torch.Tensor:

waveform, sr = torchaudio.load(audio_path)

if sr != 16000:

resampler = torchaudio.transforms.Resample(sr, 16000)

waveform = resampler(waveform)

return self.audio_transform(waveform)

5.3 代码解读与分析

上述代码实现了一个完整的vLLM多模态数据预处理流水线,主要特点包括:

- 模块化设计:使用dataclass和类方法组织代码,提高可维护性

- 类型提示:使用Python类型提示提高代码可读性和可靠性

- 错误处理:自动检查文件是否存在,避免运行时错误

- 可扩展性:易于添加新的模态或修改现有预处理流程

6. 实际应用场景

vLLM多模态数据预处理技术在以下场景中特别有用:

- 多模态对话系统:同时处理用户输入的文本、图像和语音

- 内容审核:分析社交媒体内容中的文本、图片和视频

- 教育技术:处理包含文字、图表和讲解音频的学习材料

- 医疗诊断:整合医学影像、检查报告和医生笔记

- 电子商务:分析产品描述、用户评论和产品图片

总结:未来发展趋势与挑战

vLLM在多模态数据处理领域展现出巨大潜力,未来发展趋势包括:

- 更高效的多模态融合:开发更有效的跨模态注意力机制

- 实时处理能力:优化预处理流水线以实现实时推理

- 自监督学习:利用无标注多模态数据进行预训练

- 边缘计算:在资源受限设备上部署多模态模型

面临的挑战:

- 模态间的对齐和同步问题

- 大规模多模态数据的管理和存储

- 计算资源需求与效率的平衡

- 隐私和安全问题

附录:常见问题与解答

Q1: vLLM处理多模态数据与单模态处理有何不同?

A1: vLLM处理多模态数据需要额外的模态对齐和融合步骤,且需要考虑不同模态数据的特性和处理要求。

Q2: 如何处理不同长度的多模态序列?

A2: 可以使用动态填充(padding)和掩码(masking)技术,或采用跨模态注意力机制来自适应处理不同长度的序列。

Q3: vLLM在多模态处理中的性能优势体现在哪些方面?

A3: vLLM通过优化的注意力机制和内存管理,能够高效处理大规模多模态序列,显著减少推理延迟。

Q4: 如何选择合适的分词器用于多模态处理?

A4: 应选择与下游任务模型兼容的分词器,通常使用Hugging Face提供的与预训练模型匹配的分词器。

以上就是Python使用vllm处理多模态数据的预处理技巧的详细内容,更多关于Python vllm处理多模态数据的资料请关注脚本之家其它相关文章!

相关文章

Python数据分析与可视化的全面指南(从数据清洗到图表呈现)

Python 是数据分析与可视化领域中最受欢迎的编程语言之一,凭借其丰富的库和工具,Python 能够帮助我们快速处理、分析数据并生成高质量的可视化图表,本文将详细介绍 Python 中的数据分析与可视化的基础知识,并结合丰富的示例和技巧,帮助读者深入理解这些概念2025-06-06

详解numpy.ndarray.reshape()函数的参数问题

这篇文章主要介绍了详解numpy.ndarray.reshape()函数的参数问题,文中通过示例代码介绍的非常详细,对大家的学习或者工作具有一定的参考学习价值,需要的朋友们下面随着小编来一起学习学习吧2020-10-10

最新评论