DeepSeek卡顿延迟问题怎么解决? 流畅使用DeepSeek的方法大全

智能总结:

- 文章介绍了在 DeepSeek 模型遭受攻击导致服务不稳定的情况下,如何通过不同平台和方法使用 DeepSeek 模型。DeepSeek 凭借其高性价比和优越性能在 AI 领域迅速崛起。为了避免卡顿问题,用户可以通过秘塔搜索、纳米 AI 搜索、Perplexity AI 等工具使用 DeepSeek 模型。此外,Windsurf 和 Cursor 等 AI 编辑器也支持 DeepSeek 模型,提供了更经济的调用方案。POE、SiliconFlow、字节火山引擎、百度智能云千帆和英伟达 NIM 等平台也提供了不同的 DeepSeek 模型使用方式,各有优缺点,适合不同需求的用户。

春节期间,国产 AI DeepSeek 刷屏全网,不仅在国内 App Store 免费榜登顶,还在美区力压 ChatGPT,成为现象级产品。DeepSeek 的 V3 和 R1 模型在性能上接近甚至超越 OpenAI 的 GPT-4 和 o1 ,尤其是在推理和数学任务中表现突出。另外 DeepSeek 的训练成本远低于同行,V3 模型仅用 558 万美元和 55 天完成训练,同时开源策略吸引了大量开发者参与。

然而,DeepSeek 的崛起引发了西方科技圈的恐慌,自上线以来便不断遭受来自美国 IP 地址的大规模恶意攻击,导致官方服务调用非常不稳定,只要你打开深度思考或者联网搜索就有很大概率出现卡顿或者直接挂掉的问题:

为了避免卡顿和失败的问题,下面给大家介绍一些曲线救国(非官方渠道)使用 DeepSeek 的方法。

【AI 搜索】 秘塔搜索

秘塔搜索近日宣布集成满血版 DeepSeek R1 推理模型,通过结合秘塔的数十亿全网数据和数千万学术文献资源,DeepSeek R1 能够提供更精准的搜索结果和深度推理能力。用户可以通过启用“长思考”模式,选择简洁、深入或研究三种模式,以适应不同的查询需求。这一功能不仅提升了复杂问题的解答效率,还增强了信息的真实性和可靠性。目前,该功能已在网页端上线,App端也将在后续版本中推出。

试了下,速度很快,不会出现卡顿,但是因为其主要功能是搜索,不具备上下文记忆的功能。

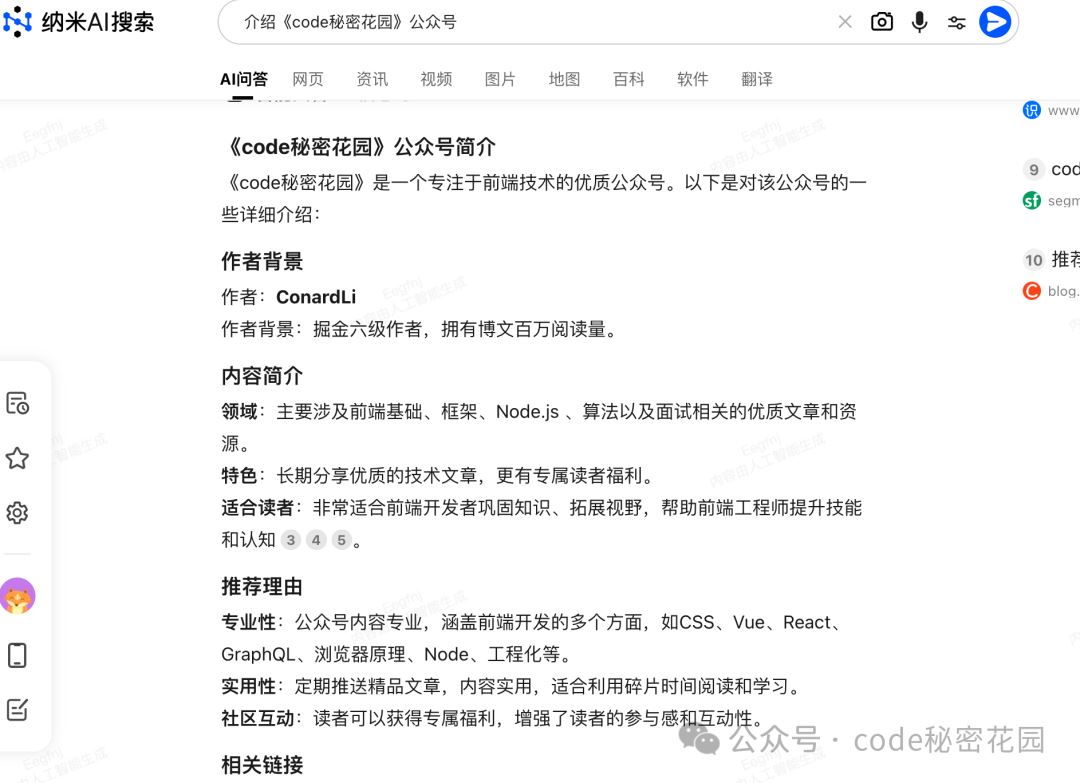

【AI 搜索】 纳米 AI 搜索

和秘塔搜索的使用方式类似,在纳米 AI 搜索中选择慢思考模式,调用的就是 DeepSeek R1 模型:

使用效果也和秘塔搜索类似,速度很快,不会出现卡顿,但是因为其主要功能是搜索,不具备上下文记忆的功能。

【AI 搜索】 Perplexity AI

Perplexity AI 是一款融合了对话式 AI 和传统网络搜索功能的智能搜索引擎,由纽约大学和加州大学校友联合创办。它通过自然语言处理技术理解用户的查询意图,并以对话形式提供精确、有深度的答案,同时附上实时网络来源的引用。Perplexity AI 支持多轮对话,用户可以在同一线程中进行后续提问,系统会保持上下文记忆。此外,它还提供多种搜索模式、文件上传分析、图像生成等功能。Perplexity AI 最近支持了最强的 DeepSeek R1 和 ChatGPT O3 模型。

Perplexity AI 的上下文记忆能力比上面两个搜索工具要强,但是缺点是需要 🪜 。

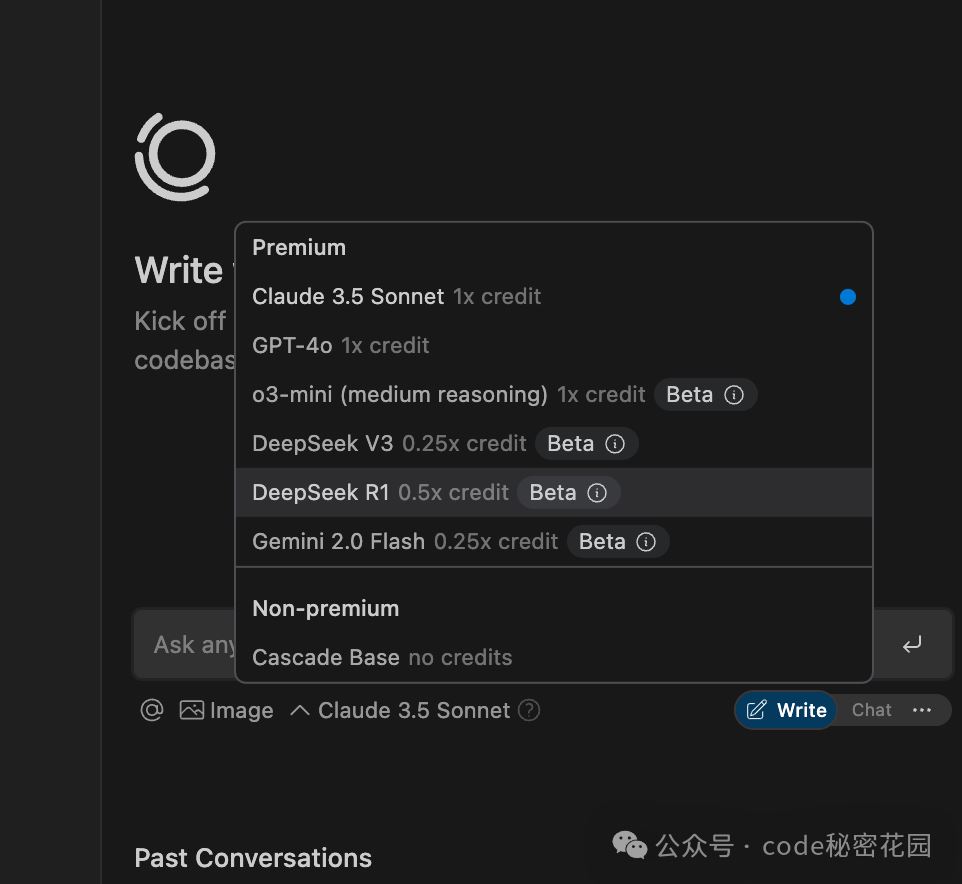

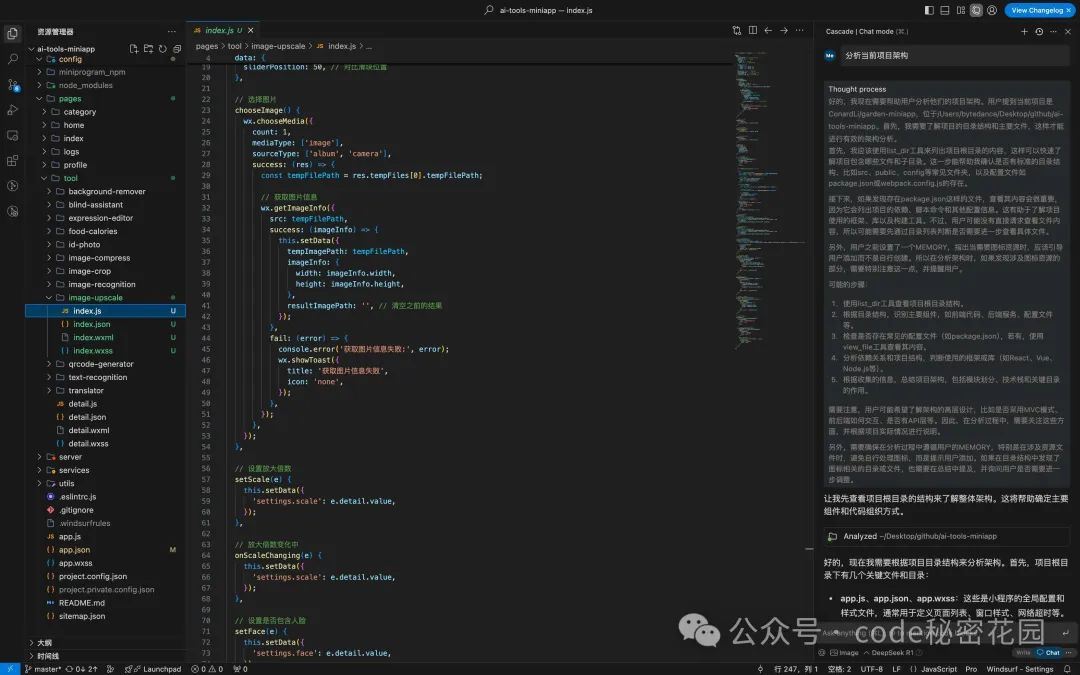

【AI 编辑器】 Windsurf

Windsurf 也在近期的版本中支持了 DeepSeek V3 和 DeepSeek R1 两个模型,令人惊喜的是,调用 DeepSeek 的消耗是有折扣的,调用 V3 只需要消耗 0.25 个 credit,调用 R1 只需要消耗 0.5 个 credit ,也就是说,如果你一直使用 DeepSeek 模型编码,你的 Pro 调用次数将会增加 2-4 倍!DeepSeek 的价格优势真正体现出来了!

试了一下,效果还可以,但是还有优化空间:

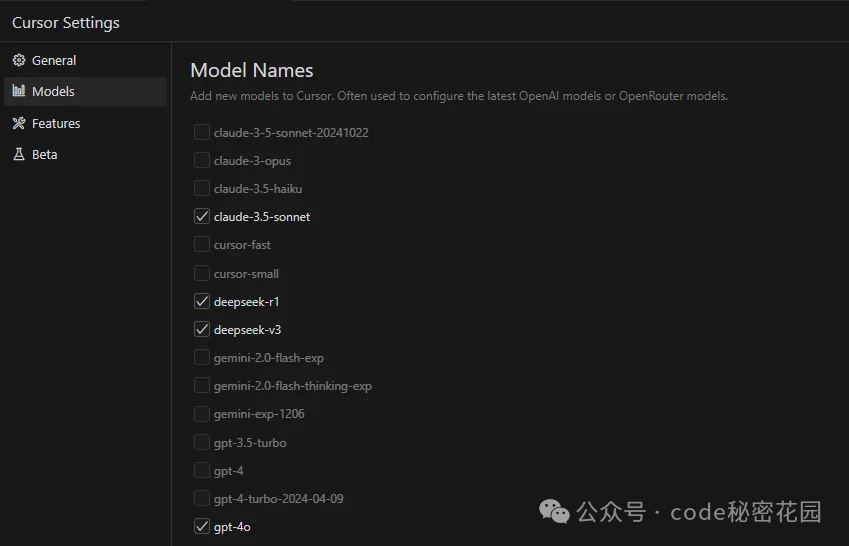

【AI 编辑器】 Cursor

Cursor 也支持了选择 DeepSeek V3 和 DeepSeek R1 两个模型:

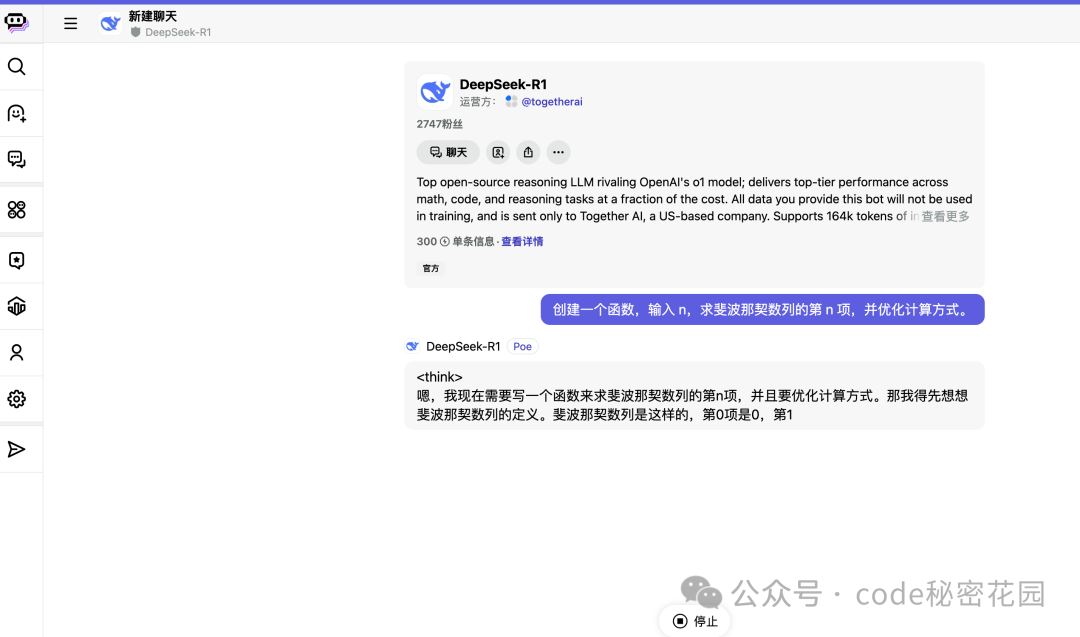

【AI 模型聚合平台】POE

POE 是个老牌的 AI 模型聚合平台,交互体验、速度都不错。

缺点就是贵,比官方贵多了,DeepSeek R1 对话一次还要花 300 积分,不差钱就用吧...

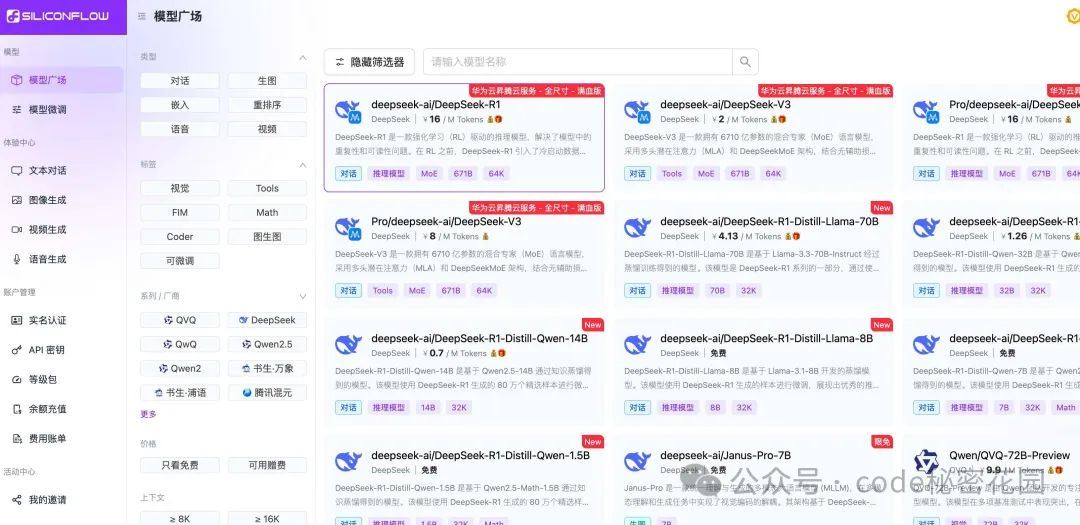

【AI 云服务平台】SiliconFlow

SiliconFlow(硅基流动)是一个集成了多种 AI 服务的平台,它提供了一个统一的登录入口,方便用户管理不同的 AI 工具,提供 IaaS、PaaS 和 MaaS 服务,集成多种主流模型,降低用户使用大模型的成本和门槛,最近刚刚支持了 DeepSeek 系列模型。

调用效果:

试了下,稳定性不错,没有出现卡顿,但是缺点也肯明显:无法联网、只能在体验模式下调用,有 Token 限制(免费赠送的额度大概可以对话 1000 次)。

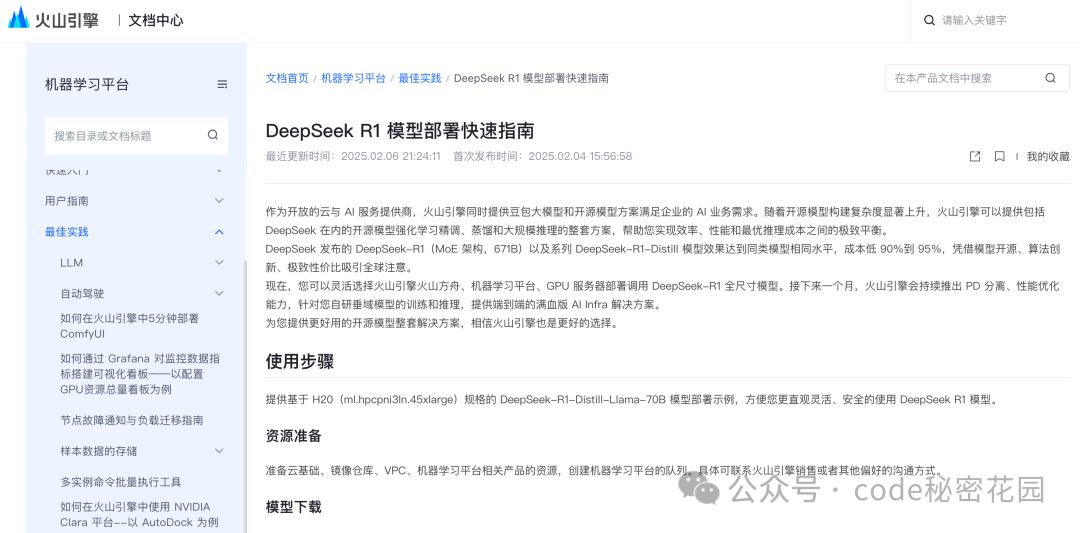

【AI 云服务平台】字节火山引擎

火山引擎支持了 V3/R1 等不同尺寸的 DeepSeek 开源模型,可以通过两种方式进行模型使用:一是在火山引擎机器学习平台 veMLP 中部署,目前 veMLP 已经支持全尺寸 DeepSeek 模型, 并仔细对 SGLang 和 vLLM 做过性能调优和效果评测,火山引擎自研 PD 分离+EP 并行的推理引擎也即将推出,全面开放。适用于自己进行模型定制、部署、推理的企业。二是在火山方舟中调用模型,适用于期望通过 API 快速集成预训练模型的企业,目前已经支持4个模型版本,并提供了全网最高的限流。

【AI 云服务平台】百度智能云千帆

百度智能云千帆平台也已正式上架 DeepSeek-R1 和 DeepSeek-V3 模型,推出了超低价格方案,R1 模型输入价格为 2 元每百万token,输出价格为 8 元每百万 token。此外,百度智能云还为用户提供了限时两周的免费体验服务,免费配额为 1000 RPM(每分钟请求数)和 10000 TPM(每分钟 Token 数),且不设调用Tokens上限。

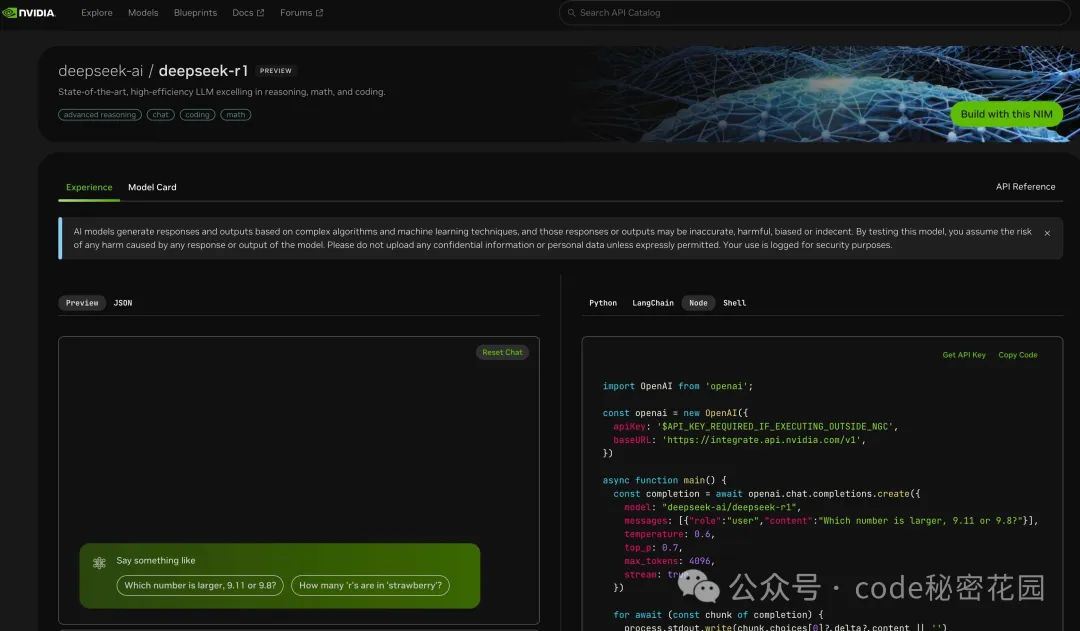

【AI 开发与计算平台】英伟达 NIM

英伟达的 NIM 平台是一个专注于 AI 模型部署和推理的平台。通过 NIM,我们可以快速部署 DeepSeek 的模型,并利用英伟达强大的 GPU 计算能力进行高效的推理。英伟达 NIM 的优势在于它的高性能和低延迟,能够让你的 AI 应用运行得更加流畅。此外,英伟达还提供了丰富的开发工具和优化方案,帮助你更好地利用 GPU 资源,从而提高 DeepSeek 的运行效率。

相关文章

优化拍照解题功能! 文小言接入DeepSeek-R1这个功能体验

接入DeepSeek R1模型后,文心一言APP的拍照解题功能得到了显著提升,用户在使用该功能时,可以清晰地看到解题过程中的思考步骤,这与DeepSeek特有的思维链功能非常相似2025-02-12

2025职场人必备AI神器! DeepSeek配合KIMI自动生成PPT

幸运的是,2025年,AI“杀”到了职场,继豆包、Kimi之后,这个春节,DeepSeek又震惊中外,AI的强大功能,正在一次又一次颠覆人们的认知,今天我们就来看看使用KIMI和DeepSee2025-02-10 有人发现,使用deepseek不能直接输出excel表格,真的不能吗?其实是可以的,下面我们就来分享小技巧2025-02-10

有人发现,使用deepseek不能直接输出excel表格,真的不能吗?其实是可以的,下面我们就来分享小技巧2025-02-10

DeepSeek怎么做哪吒2介绍PPT? 一分钟用deepseek生成PPT的技巧

最近看了哪吒2,想要利用DeepSeek快速制作一篇哪吒2电影推广文案,该怎么制作ppt呢?下面我们就来看看详细教程2025-02-11

DeepSeek R1 671B 完整版本地部署详尽教程来了!

关于本地部署,大多数人使用的是蒸馏后的8B/32B/70B版本,本质是微调后的Llama或Qwen模型,并不能完全发挥出DeepSeek R1的实力,下面我们就来看看DeepSeek R1 671B 完整版2025-02-09 想不想让你的微信也变得智能起来?今天咱聊聊怎么把DeepSeek这个超强AI助手接入到你的微信里,让它24小时随叫随到,啥问题都能秒回你2025-02-09

想不想让你的微信也变得智能起来?今天咱聊聊怎么把DeepSeek这个超强AI助手接入到你的微信里,让它24小时随叫随到,啥问题都能秒回你2025-02-09 很多人竟还没用过,或者说还不会用DeepSeek,普通人该怎么上手呢?下面我们就来看看Deepseek使用攻略2025-02-09

很多人竟还没用过,或者说还不会用DeepSeek,普通人该怎么上手呢?下面我们就来看看Deepseek使用攻略2025-02-09 如果你是内容创作者,或者在数字营销、数据分析等领域工作,提升工作效率和创作水平是必不可少的,而掌握一些强大的创作指令,无疑能让你事半功倍!今天,我整理了20个Deep2025-02-09

如果你是内容创作者,或者在数字营销、数据分析等领域工作,提升工作效率和创作水平是必不可少的,而掌握一些强大的创作指令,无疑能让你事半功倍!今天,我整理了20个Deep2025-02-09 这几天,我在疯狂使用DeepSeek 写各类文章,自媒体爆文、短篇故事文、营销文案、剧本等等……这就来分享DeepSeek提示词攻略2025-02-09

这几天,我在疯狂使用DeepSeek 写各类文章,自媒体爆文、短篇故事文、营销文案、剧本等等……这就来分享DeepSeek提示词攻略2025-02-09

看到满血版价格想想还是算了! 本地部署 DeepSeek 电脑硬件配置清单

针对本地部署DeepSeek大模型的配置需求,需根据模型规模(如7B/13B/70B参数)和量化方案进行区分,以下是三个层级的硬件配置建议2025-02-09

最新评论